- Autore Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- Ultima modifica 2025-01-22 17:28.

Per abilitare il server della cronologia Spark:

- Creare una directory per i log degli eventi nel file system DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Quando la registrazione degli eventi è abilitata, il comportamento predefinito prevede il salvataggio di tutti i registri, il che fa sì che l'archiviazione aumenti nel tempo.

Oltre a questo, come posso configurare un server Spark History?

Per abilitare il server della cronologia Spark:

- Creare una directory per i log degli eventi nel file system DSEFS: dse hadoop fs -mkdir /spark $ dse hadoop fs -mkdir /spark/events.

- Quando la registrazione degli eventi è abilitata, il comportamento predefinito prevede il salvataggio di tutti i registri, il che fa sì che l'archiviazione aumenti nel tempo.

Allo stesso modo, come posso trovare l'URL del mio server Spark History? Ad es., per il server della cronologia , in genere sarebbero accessibili all'indirizzo server - URL >:18080/api/v1 e per un'applicazione in esecuzione su https://localhost:4040/api/v1. Nell'API, un'applicazione è referenziata dal suo ID applicazione, [app-id].

Allo stesso modo, cos'è il server Spark History?

Il Il server della cronologia di Spark è uno strumento di monitoraggio che visualizza informazioni su completato Scintilla applicazioni. Questa informazione è estratti dai dati che le applicazioni scrivono per impostazione predefinita in una directory su Hadoop Distributed File System (HDFS).

Cos'è Sparkui?

L'interfaccia utente Web di Spark consente di visualizzare un elenco di fasi e attività dell'utilità di pianificazione, informazioni sull'ambiente, informazioni sugli executor in esecuzione e altro ancora. Guarda questa demo di 30 minuti per informazioni su: Componenti e ciclo di vita di un programma Spark. Come viene eseguita l'applicazione Spark su un cluster Hadoop.

Consigliato:

Come faccio ad avviare un server bitbucket?

Per avviare Bitbucket Data Center (non avvia l'istanza Elasticsearch in bundle di Bitbucket) Passa a Esegui questo comando: start-bitbucket.sh --no-search

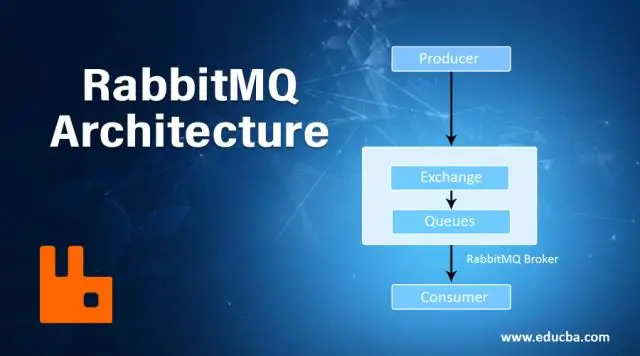

Come faccio ad avviare il server RabbitMQ?

Dal menu Start di Windows, selezionare Tutti i programmi > RabbitMQ Server > Avvia servizio per avviare il server RabbitMQ. Il servizio viene eseguito nel contesto di sicurezza dell'account di sistema senza richiedere l'accesso di un utente su una console. Utilizzare lo stesso processo per arrestare, reinstallare e rimuovere il servizio

Come faccio ad avviare una presentazione sul mio iPad?

Per utilizzare la funzione di presentazione, segui questi passaggi: Tocca l'icona dell'app Foto per aprire l'applicazione. Tocca la scheda Foto. Tocca il pulsante Presentazione per visualizzare il menu Opzioni presentazione. Se desideri riprodurre musica insieme alla presentazione, tocca il pulsante On/Off nel campo Riproduci musica

Come faccio ad avviare il mio Raspberry Pi 4?

Collegare i cavi della tastiera, del mouse e del monitor Collegare la tastiera. Collega una normale tastiera per PC (o Mac) cablata a una delle quattro prese USB A più grandi su un Raspberry Pi 4. Collega un mouse. Collega un mouse cablato USB a una delle altre prese USB A più grandi su Raspberry Pi. Collegare il cavo micro-HDMI

Come faccio ad avviare il mio Galaxy a5 in modalità provvisoria?

Come posso utilizzare la modalità provvisoria sul mio Galaxy A5? Tieni premuto il tasto Volume giù. Tenendo premuto continuamente il tasto Volume, premere brevemente il tasto di accensione per accendere il dispositivo. Il dispositivo si accenderà in modalità provvisoria. Scorri lo schermo: l'icona della modalità provvisoria sarà ancora visualizzata. Tocca App. Tocca Impostazioni. Scorri verso il basso e tocca Gestione applicazioni