- Autore Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:49.

- Ultima modifica 2025-01-22 17:28.

In parole povere, il se stesso - Attenzione meccanismo consente agli input di interagire tra loro (“ se stesso ”) e scopri chi dovrebbero pagare di più Attenzione a (" Attenzione "). Le uscite sono aggregati di queste interazioni e Attenzione punteggi.

Inoltre, cos'è l'attenzione al Sé?

Se stesso - Attenzione , talvolta chiamato intra- Attenzione è un Attenzione meccanismo che mette in relazione diverse posizioni di una singola sequenza al fine di calcolare una rappresentazione della sequenza.

Inoltre, cos'è l'auto-attenzione nell'apprendimento profondo? Innanzitutto, definiamo cosa “ se stesso - Attenzione " è. Cheng et al, nel loro articolo intitolato "Long Short-Term Memory-Networks for Macchina Lettura”, definito se stesso - Attenzione come il meccanismo di mettere in relazione diverse posizioni di una singola sequenza o frase al fine di ottenere una rappresentazione più vivida.

A questo proposito, cos'è il meccanismo di attenzione?

Meccanismo di attenzione consente al decodificatore di occuparsi di diverse parti della frase sorgente in ogni fase della generazione dell'output. Invece di codificare la sequenza di input in un singolo vettore di contesto fisso, lasciamo che il modello impari come generare un vettore di contesto per ogni fase temporale di output.

Che cos'è il modello basato sull'attenzione?

Attenzione - modelli basati appartengono a una classe di Modelli comunemente chiamato sequenza-sequenza Modelli . Lo scopo di questi Modelli , come suggerisce il nome, produce una sequenza di output data una sequenza di input che sono, in generale, di lunghezze diverse.

Consigliato:

Come funziona il proxy Spring AOP?

Proxy AOP: un oggetto creato dal framework AOP al fine di implementare i contratti di aspetto (avviare l'esecuzione di metodi e così via). In Spring Framework, un proxy AOP sarà un proxy dinamico JDK o un proxy CGLIB. Tessitura: collegamento di aspetti con altri tipi di applicazioni o oggetti per creare un oggetto consigliato

Come funziona una TV a specchio?

Una TV a specchio è costituita da uno speciale vetro a specchio semitrasparente con una TV LCD dietro la superficie a specchio. Lo specchio è accuratamente polarizzato per consentire il trasferimento di un'immagine attraverso lo specchio, in modo tale che quando la TV è spenta, il dispositivo assomigli a uno specchio

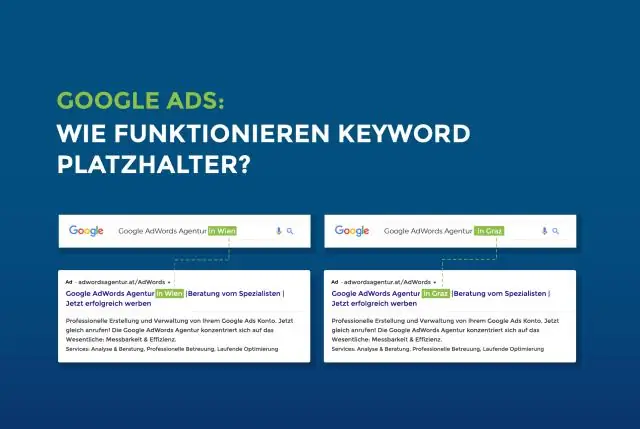

Come funziona il segnaposto?

L'attributo segnaposto specifica un breve suggerimento che descrive il valore previsto di un campo di input (ad esempio un valore di esempio o una breve descrizione del formato previsto). Nota: l'attributo segnaposto funziona con i seguenti tipi di input: testo, ricerca, url, tel, e-mail e password

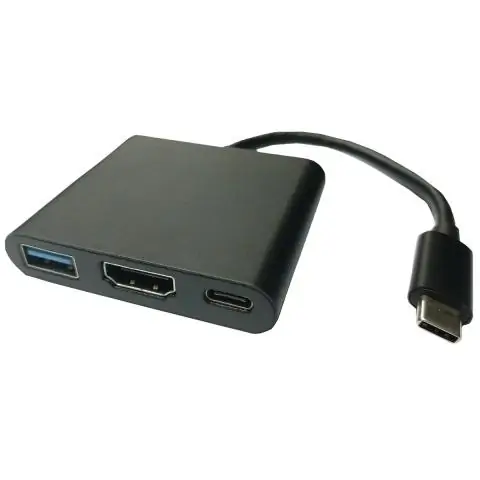

Come funziona un adattatore display USB?

Gli adattatori video USB sono dispositivi che accettano una porta USB e collegano una o più connessioni video, come VGA, DVI, HDMI o DisplayPort. Questo è utile se desideri aggiungere un display aggiuntivo alla configurazione del tuo computer, ma non hai connessioni video sul tuo computer

I byte e i caratteri sono gli stessi?

I caratteri NON sono gli stessi dei byte. Il termine carattere è un termine logico (nel senso che definisce qualcosa nei termini del modo in cui le persone pensano alle cose). Il termine byte è un termine di dispositivo (nel senso che definisce qualcosa in termini di come è stato progettato l'hardware). La differenza sta nella codifica