- Autore Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- Ultima modifica 2025-01-22 17:29.

Inizia il Scintilla Master su più nodi e assicurati che questi nodi abbiano lo stesso guardiano dello zoo configurazione per Custode dello zoo URL e directory.

Informazione.

| Proprietà di sistema | Significato |

|---|---|

| scintilla .distribuire. guardiano dello zoo .dir | La directory in Custode dello zoo per memorizzare lo stato di ripristino (predefinito: / scintilla ). Questo può essere facoltativo |

Di conseguenza, puoi eseguire spark localmente?

Spark può essere correre utilizzando l'utilità di pianificazione del cluster standalone integrata nel Locale modalità. Ciò significa che tutti i Scintilla i processi sono correre all'interno della stessa JVM, una singola istanza multithread di Scintilla.

In secondo luogo, Spark può essere utilizzato senza Hadoop? Come per Scintilla documentazione, Spark può correre senza Hadoop . Puoi eseguirlo come modalità autonoma privo di qualsiasi gestore di risorse. Ma se vuoi eseguire una configurazione multi-nodo, hai bisogno di un gestore di risorse come YARN o Mesos e un file system distribuito come HDFS , S3 ecc. Sì, scintilla può correre senza hadoop.

Inoltre, c'è da sapere perché ZooKeeper viene utilizzato in Hadoop?

guardiano dello zoo in Hadoop può essere visto come un repository centralizzato in cui le applicazioni distribuite possono inserire dati e ricavarne dati. è Usato per mantenere il sistema distribuito funzionante insieme come una singola unità, utilizzando i suoi obiettivi di sincronizzazione, serializzazione e coordinamento.

Come funziona Spark autonomo?

Indipendente, autonomo mode è un semplice gestore cluster incorporato con Scintilla . Semplifica la configurazione di un cluster che Scintilla stesso gestisce e può essere eseguito su Linux, Windows o Mac OSX. Spesso è il modo più semplice per correre Scintilla applicazione in un ambiente cluster. Impara, come installare Apache Spark Sopra Indipendente, autonomo Modalità.

Consigliato:

Che cos'è il join laterale MAP in spark?

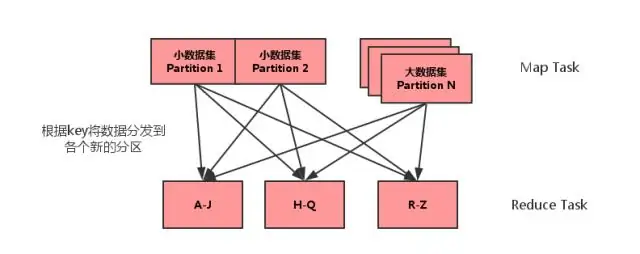

Il join lato mappa è un processo in cui i join tra due tabelle vengono eseguiti nella fase Mappa senza il coinvolgimento della fase Riduci. I join lato mappa consentono di caricare una tabella in memoria garantendo un'operazione di join molto veloce, eseguita interamente all'interno di un mappatore e anche questo senza dover utilizzare sia la mappa che le fasi di riduzione

Cosa c'è di nuovo in Spark?

Oltre alle correzioni di bug, ci sono 2 nuove funzionalità in Spark 2.4: SPARK-22239 Funzioni della finestra definite dall'utente con Pandas UDF. SPARK-22274 Funzioni di aggregazione definite dall'utente con pandas udf. Riteniamo che queste nuove funzionalità miglioreranno ulteriormente l'adozione di Pandas UDF e continueremo a migliorare Pandas UDF nelle prossime versioni

Devo imparare Hadoop per Spark?

No, non è necessario imparare Hadoop per imparare Spark. Spark era un progetto indipendente. Ma dopo YARN e Hadoop 2.0, Spark è diventato popolare perché Spark può essere eseguito su HDFS insieme ad altri componenti Hadoop. Hadoop è un framework in cui scrivi il lavoro MapReduce ereditando le classi Java

Quale versione di Python utilizza Spark?

Spark funziona su Java 8+, Python 2.7+/3.4+ e R 3.1+. Per l'API Scala, Spark 2.3. 0 usa Scala 2.11. Dovrai usare una versione Scala compatibile (2.11

Come si configura l'instant messenger Spark?

Guida alla configurazione di Spark IM Scarica Spark dal sito Web di Spark IM. Installa e avvia Spark sul tuo computer. Inserisci il tuo nome utente Olark nel campo in alto, la tua password nel campo centrale e "@olark.com" per il dominio. Premi invio e verrai connesso a Spark IM! Buone chat