- Autore Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- Ultima modifica 2025-01-22 17:28.

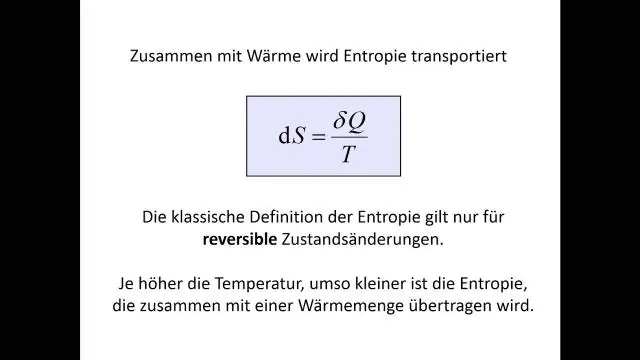

entropia : UN albero decisionale è costruito dall'alto verso il basso da un nodo radice e prevede il partizionamento dei dati in sottoinsiemi che contengono istanze con valori simili (omogenei). L'algoritmo ID3 utilizza entropia calcolare l'omogeneità di un campione.

Le persone chiedono anche, qual è la definizione di entropia nell'apprendimento automatico?

entropia , per quanto riguarda apprendimento automatico , è una misura della casualità delle informazioni in elaborazione. Più alto è entropia , tanto più difficile è trarre conclusioni da tali informazioni. Lanciare una moneta è un esempio di un'azione che fornisce informazioni casuali. Questa è l'essenza di entropia.

Oltre a quanto sopra, qual è il guadagno di informazioni e l'entropia nell'albero decisionale? Il guadagno di informazioni si basa sulla diminuzione di entropia dopo che un set di dati è stato suddiviso su un attributo. Costruire un albero decisionale si tratta di trovare l'attributo che restituisce il più alto guadagno di informazioni (cioè i rami più omogenei). Il risultato è il Guadagno di informazioni , o diminuire in entropia.

Sappi anche, qual è il valore minimo di entropia in un albero decisionale?

entropia è più basso agli estremi, quando la bolla non contiene istanze positive o solo istanze positive. Cioè, quando la bolla è pura il disordine è 0. entropia è più alto al centro quando la bolla è divisa equamente tra istanze positive e negative.

Cos'è l'entropia nella foresta casuale?

Cos'è l'entropia? e perché l'acquisizione di informazioni è importante? Decisione Alberi? Nasir Islam Sujan. 29 giu 2018 · 5 min di lettura. Secondo Wikipedia, entropia si riferisce al disordine o all'incertezza. Definizione: entropia sono le misure di impurità, disordine o incertezza in una serie di esempi.

Consigliato:

Come funziona l'albero decisionale in R?

L'albero decisionale è un tipo di algoritmo di apprendimento supervisionato che può essere utilizzato sia in problemi di regressione che di classificazione. Funziona per variabili di input e output sia categoriali che continue. Quando un sottonodo si divide in ulteriori sottonodi, viene chiamato Nodo decisionale

Come si trova l'accuratezza di un albero decisionale?

Precisione: il numero di previsioni corrette fatte diviso per il numero totale di previsioni fatte. Prevediamo la classe di maggioranza associata a un particolare nodo come True. cioè usa l'attributo di valore più grande da ogni nodo

Come si implementa un albero decisionale in Python?

Durante l'implementazione dell'albero decisionale, attraverseremo le due fasi seguenti: Fase di costruzione. Preelabora il set di dati. Dividere il set di dati da addestrare e testare utilizzando il pacchetto sklearn di Python. Allena il classificatore. Fase Operativa. Fare previsioni. Calcola la precisione

Qual è la profondità di un albero decisionale?

La profondità di un albero decisionale è la lunghezza del percorso più lungo da una radice a una foglia. La dimensione di un albero decisionale è il numero di nodi nell'albero. Nota che se ogni nodo dell'albero decisionale prende una decisione binaria, la dimensione può essere grande come 2d+1−1, dove d è la profondità

Che tipo di problemi sono più adatti per l'apprendimento dell'albero decisionale?

Problemi appropriati per l'apprendimento dell'albero decisionale L'apprendimento dell'albero decisionale è generalmente più adatto a problemi con le seguenti caratteristiche: Le istanze sono rappresentate da coppie attributo-valore. Esiste un elenco finito di attributi (ad es. colore dei capelli) e ogni istanza memorizza un valore per quell'attributo (ad es. biondo)