- Autore Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:49.

- Ultima modifica 2025-01-22 17:28.

I file di configurazione che devono essere aggiornati per configurare una modalità completamente distribuita di Hadoop sono:

- Hadoop-env.sh.

- Sito principale. xml.

- Hdfs-sito. xml.

- Mapred-sito. xml.

- Maestri.

- Schiavi.

Inoltre, quali sono i file di configurazione importanti in Hadoop?

La configurazione di Hadoop è guidata da due tipi di file di configurazione importanti:

- Configurazione predefinita di sola lettura: src/core/core-default. xml, src/hdfs/hdfs-default. xml e src/mapred/mapred-default. xml.

- Configurazione specifica del sito - conf/core-site. xml, conf/hdfs-site. xml e conf/mapred-site. xml.

Allo stesso modo, quali delle seguenti contengono la configurazione per i demoni HDFS? xml contiene la configurazione impostazioni di Demoni HDFS (ovvero NameNode, DataNode, Secondary NameNode). Include anche il fattore di replica e la dimensione del blocco di HDFS.

cosa sono i file di configurazione in Hadoop?

File di configurazione sono i File che si trovano nel catrame estratto. gz file nell'ecc/ hadoop / directory. Tutto File di configurazione in Hadoop sono elencati di seguito, 1) HADOOP -ENV.sh->>Specifica le variabili di ambiente che influenzano il JDK utilizzato da Hadoop Demone (bin/ hadoop ).

Quali file si occupano di piccoli problemi di file in Hadoop?

1) HAR ( Hadoop Archivio) File è stato presentato a affrontare problemi di file di piccole dimensioni . HAR ha introdotto uno strato sopra HDFS , che forniscono l'interfaccia per file accesso. Usando Hadoop comando di archiviazione, HAR File vengono creati, che esegue un Riduci mappa lavoro per imballare il File essere archiviato in più piccoli numero di File HDFS.

Consigliato:

Quali sono i principali parametri di configurazione che l'utente deve specificare per eseguire il lavoro MapReduce?

I principali parametri di configurazione che gli utenti devono specificare nel framework "MapReduce" sono: Le posizioni di input del lavoro nel file system distribuito. Posizione di output del lavoro nel file system distribuito. Formato di input dei dati. Formato di output dei dati. Classe contenente la funzione map. Classe contenente la funzione di riduzione

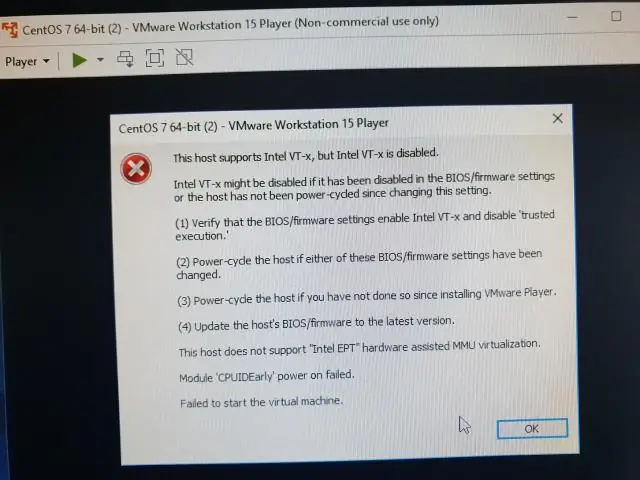

Quali opzioni devono essere abilitate per eseguire Hyper V?

Domanda 2 Quali opzioni hardware devono essere abilitate per eseguire Hyper-V? L'opzione di virtualizzazione hardware hardware (Intel VT/AMD-V) e Data Execution Prevention (Intel DX/AMD NX) devono essere abilitate per eseguire Hyper-V

Quali sono le parti più importanti del sistema di controllo*?

I controlli di feedback sono ampiamente utilizzati nei moderni sistemi automatizzati. Un sistema di controllo in retroazione è costituito da cinque componenti di base: (1) ingresso, (2) processo da controllare, (3) uscita, (4) elementi di rilevamento e (5) controller e dispositivi di attuazione

Quali sono le note del relatore per scrivere il suo scopo e quali sono le cose fondamentali da ricordare sulle note del relatore?

Le note del relatore sono testi guidati che il relatore utilizza durante la presentazione di una presentazione. Aiutano il presentatore a ricordare i punti importanti durante la presentazione. Appaiono sulla diapositiva e possono essere visualizzati solo dal presentatore e non dal pubblico

Quali sono alcune sfide che i manager devono affrontare quando comunicano con i team virtuali?

Di seguito è riportata una panoramica delle sfide del team virtuale e della loro gestione. Riunioni online facili e gratuite. Gratuito fino a 100 partecipanti. Povera comunicazione. Mancanza di interazione sociale. Mancanza di fiducia. Diverse squadre multiculturali. Perdita di morale e spirito di squadra. Distanza fisica. Differenze di fuso orario