- Autore Lynn Donovan [email protected].

- Public 2024-01-18 08:25.

- Ultima modifica 2025-01-22 17:28.

I principali parametri di configurazione che gli utenti devono specificare nel framework “MapReduce” sono:

- Lavori posizioni di input nel file system distribuito.

- Lavori posizione di output nel file system distribuito.

- Formato di input dei dati.

- Formato di output dei dati.

- Classe contenente la funzione map.

- Classe contenente la funzione di riduzione.

Quali sono i principali parametri di configurazione di un programma MapReduce?

I principali parametri di configurazione nel framework “MapReduce” sono:

- Posizione di input dei lavori nel file system distribuito.

- Posizione di output dei lavori nel file system distribuito.

- Il formato di input dei dati.

- Il formato di output dei dati.

- La classe che contiene la funzione map.

- La classe che contiene la funzione reduce.

Ci si potrebbe anche chiedere, quali sono i parametri di mappatori e riduttori? I quattro parametri per i mappatori sono:

- LongWritable (ingresso)

- l'immissione di testo)

- testo (output intermedio)

- IntWritable (output intermedio)

Inoltre, la domanda è: quali sono i componenti principali del lavoro MapReduce?

- Classe driver principale che fornisce i parametri di configurazione del lavoro.

- Classe Mapper che deve estendere org. apache. hadoop. Riduci mappa. Mapper e fornisce l'implementazione per il metodo map().

- Classe riduttore che dovrebbe estendere org. apache. hadoop. Riduci mappa. Classe riduttore.

Che cos'è il partizionatore e come aiuta nel processo di lavoro di MapReduce?

partizionatore in MapReduce lavoro l'esecuzione controlla il partizionamento delle chiavi delle uscite mappa intermedie. Con il aiuto della funzione hash, la chiave (o un sottoinsieme della chiave) deriva il partizione . I record che hanno lo stesso valore chiave vanno nello stesso partizione (all'interno di ogni mappatore).

Consigliato:

Quali sono i file di configurazione importanti che devono essere aggiornati modificati per configurare una modalità completamente distribuita del cluster Hadoop?

I file di configurazione che devono essere aggiornati per configurare una modalità completamente distribuita di Hadoop sono: Hadoop-env.sh. Sito principale. xml. Hdfs-sito. xml. Mapred-sito. xml. Maestri. schiavi

Quali sono le due cose che l'OCA deve considerare quando determina per quanto tempo verranno classificate le informazioni?

Il nome del sistema, piano, programma o progetto; l'appuntamento; l'ufficio che rilascia la guida, identificato per nome o codice identificativo personale e posizione; l'OCA che approva la guida; una dichiarazione di sostituzione, se necessaria; e una dichiarazione di distribuzione

Quali sono i principali fattori che stanno guidando l'internazionalizzazione delle imprese?

Quali sono i principali fattori che stanno guidando l'internazionalizzazione delle imprese? La crescita di comunicazioni e trasporti internazionali poco costosi ha creato una cultura mondiale con aspettative o norme stabili. Anche la stabilità politica e una base di conoscenza globale in crescita e ampiamente condivisa contribuiscono alla cultura mondiale

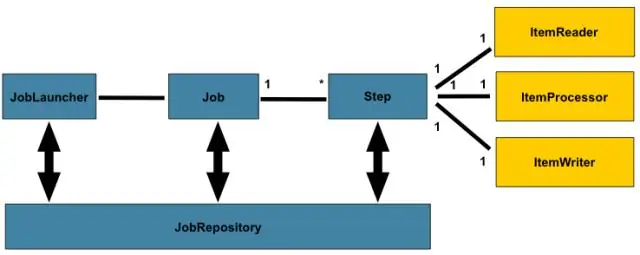

Che cosa sono i parametri del lavoro in Spring Batch?

JobParameters è un insieme di parametri utilizzati per avviare un lavoro batch. I JobParameters possono essere utilizzati per l'identificazione o anche come dati di riferimento durante l'esecuzione del lavoro. Hanno nomi riservati, quindi per accedervi possiamo usare Spring Expression Language

Che cos'è un sistema operativo e quali sono le quattro funzioni principali del sistema operativo?

Un sistema operativo (OS) è un'interfaccia tra un utente di computer e l'hardware del computer. Un sistema operativo è un software che esegue tutte le attività di base come la gestione dei file, la gestione della memoria, la gestione dei processi, la gestione di input e output e il controllo di dispositivi periferici come unità disco e stampanti