- Autore Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- Ultima modifica 2025-01-22 17:28.

Localizzazione dei dati in Hadoop . Prendi l'esempio di Wordcount, in cui la maggior parte delle parole è stata ripetuta per 5 Lac o più volte. In tal caso, dopo la fase Mapper, ogni uscita Mapper avrà parole nell'intervallo di 5 Lacs. Questo processo completo di memorizzazione dell'output di Mapper in LFS è chiamato come Localizzazione dei dati.

Tenendo presente questo, cos'è la localizzazione dei dati in Hadoop?

Il concetto di Dati località in Dati Hadoop località in Riduci mappa si riferisce alla capacità di spostare il calcolo vicino al punto in cui l'effettivo dati risiede sul nodo, invece di spostarsi di grandi dimensioni dati al calcolo. Ciò riduce al minimo la congestione della rete e aumenta il throughput complessivo del sistema.

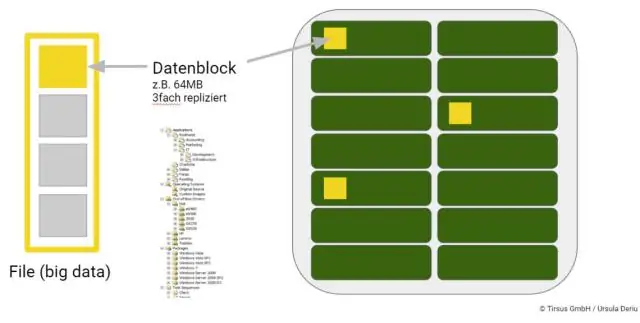

Inoltre, come vengono archiviati i big data? La maggior parte delle persone associa automaticamente HDFS, o Hadoop Distributed File System, ad Hadoop dati magazzini. HDFS archivia le informazioni in cluster costituiti da blocchi più piccoli. Questi blocchi sono immagazzinato nel fisico in loco Conservazione unità, come le unità disco interne.

Proprio così, come vengono archiviati i dati in Hadoop?

su un Hadoop cluster, il dati all'interno di HDFS e il sistema MapReduce sono ospitati su ogni macchina del cluster. Dati è immagazzinato in dati blocchi sui DataNode. HDFS replica quelli dati blocchi, in genere di dimensioni pari a 128 MB, e li distribuisce in modo che vengano replicati all'interno di più nodi del cluster.

Come vengono archiviati i file in HDFS?

HDFS espone a file spazio dei nomi di sistema e consente ai dati dell'utente di essere immagazzinato in File . Internamente, a file è diviso in uno o più blocchi e questi blocchi sono immagazzinato in un insieme di DataNode. Il NameNode viene eseguito file operazioni dello spazio dei nomi di sistema come apertura, chiusura e ridenominazione File e directory.

Consigliato:

Come si ottiene l'astrazione dei dati?

L'astrazione sta selezionando i dati da un pool più ampio per mostrare solo i dettagli rilevanti per l'oggetto. Aiuta a ridurre la complessità e lo sforzo di programmazione. In Java, l'astrazione viene eseguita utilizzando classi e interfacce astratte. È uno dei concetti più importanti di OOP

Perché l'archiviazione dei dati orientata alle colonne rende l'accesso ai dati sui dischi più veloce rispetto all'archiviazione dei dati orientata alle righe?

I database orientati alle colonne (noti anche come database colonnari) sono più adatti per i carichi di lavoro analitici perché il formato dei dati (formato colonna) si presta a un'elaborazione più rapida delle query: scansioni, aggregazioni, ecc. D'altra parte, i database orientati alle righe memorizzano una singola riga (e tutte le sue colonne) in modo contiguo

Come si ottiene l'analisi dei dati su Excel 2011 per Mac?

Nella casella Componenti aggiuntivi disponibili selezionare la casella di controllo AnalysisToolPak - VBA. Nota: Strumenti di analisi non è disponibile per Excel per Mac 2011. Caricare Strumenti di analisi in Excel Fare clic sulla scheda File, fare clic su Opzioni e quindi fare clic sulla categoria Aggiungi-In. Nella casella Gestisci, seleziona Componenti aggiuntivi di Excel e quindi fai clic su Vai

Come viene utilizzato Hadoop nell'analisi dei dati?

Hadoop è un framework software open source che fornisce l'elaborazione di grandi set di dati su cluster di computer utilizzando semplici modelli di programmazione. Hadoop è progettato per scalare da singoli server a migliaia di macchine

Che cos'è la gestione dei dati dei test TDM?

Test Data Management (TDM) è l'amministrazione dei dati necessari per soddisfare le esigenze dei processi di test automatizzati. TDM dovrebbe anche garantire la qualità dei dati, nonché la loro disponibilità al momento giusto