- Autore Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- Ultima modifica 2025-01-22 17:28.

Mentre Scintilla supporta il caricamento File dal Locale filesystem, richiede che il File sono disponibili nello stesso percorso su tutti i nodi del cluster. Alcuni filesystem di rete, come NFS, AFS e il livello NFS di MapR, sono esposti all'utente come un normale filesystem.

Successivamente, ci si potrebbe anche chiedere, come posso eseguire spark in modalità locale?

In modalità locale , scintilla lavori correre su una singola macchina e vengono eseguiti in parallelo utilizzando il multi-threading: questo limita il parallelismo (al massimo) al numero di core nella tua macchina. Per correre lavori in modalità locale , devi prima prenotare una macchina tramite SLURM in modalità interattiva modalità e accedi ad esso.

Oltre a sopra, cos'è SC textFile? file di testo è un metodo di un'org. apache. SparkContext classe che legge a file di testo da HDFS, un file system locale (disponibile su tutti i nodi) o qualsiasi URI del file system supportato da Hadoop e restituirlo come RDD di stringhe.

A questo proposito, cos'è un file spark?

Il File Spark è un documento dove conservi tutta la tua bontà creativa. È stato definito dall'autore Stephen Johnson. Quindi, invece di scrivere appunti su un Post-it® nel cuore della notte o dedicare diversi diari alle idee, metti tutti i tuoi concetti in uno file.

Cos'è la scintilla di raccolta parallelizzata?

Descriveremo le operazioni su set di dati distribuiti in seguito. Collezioni parallelizzate vengono creati chiamando JavaSparkContext 's parallelizzare metodo su un esistente Collezione nel tuo programma di guida. Gli elementi del collezione vengono copiati per formare un set di dati distribuito su cui è possibile operare in parallelo.

Consigliato:

Python può leggere i file ZIP?

Per lavorare sui file zip usando python, useremo un modulo python integrato chiamato zipfile. print ('Fatto!' ZipFile è una classe di modulo zipfile per leggere e scrivere file zip. Qui importiamo solo la classe ZipFile dal modulo zipfile

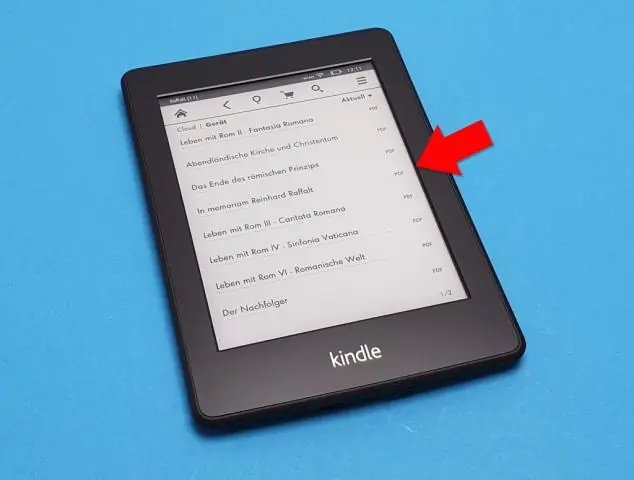

Il finale può leggere i file PDF?

Suggerimento: puoi anche aprire il file in Finale selezionando il file nel Finder e facendo clic con il pulsante destro del mouse. Quindi seleziona “Apri con…” e scegli Finale nella barra del programma. Congratulazioni! Hai importato con successo un file PDF in Finale usando ScanScore

Nook può leggere i file PDF?

Documenti che puoi aggiungere ai PDF Nookinclude, che possono essere libri o altri documenti più brevi. I PDF su Nook possono essere letti come qualsiasi altro libro acquistato e puoi sincronizzare il dispositivo, copiando i documenti dal tuo computer a Nook. Fai doppio clic sulla cartella "Libri" o "Documenti" sull'unità di Nook

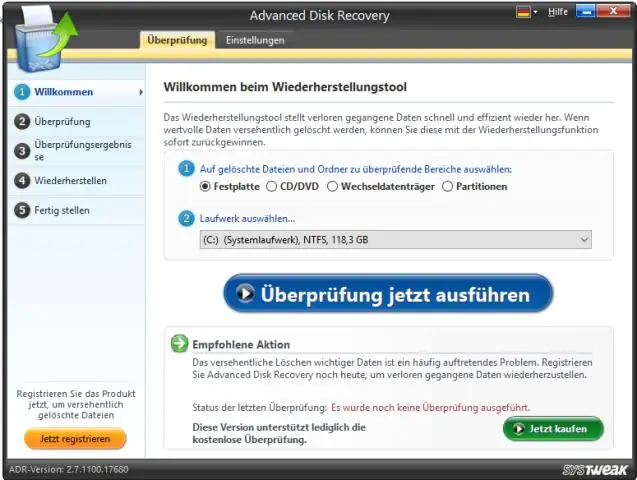

Windows 10 può leggere i file raw?

Windows 10 non viene fornito con il supporto nativo per l'anteprima dei file di immagine non elaborati, il che significa che gli utenti non possono visualizzare le miniature o i metadati nell'app Foto o Esplora file di Windows. Tuttavia, Microsoft ha una soluzione per i fotografi che necessitano di questa funzionalità e si chiama Raw Image Extension

Python può leggere i file.MAT?

A partire dalla versione 7.3 di Matlab, i file mat vengono effettivamente salvati utilizzando il formato HDF5 per impostazione predefinita (tranne se si utilizza il flag -vX al momento del salvataggio, vedere in Matlab). Questi file possono essere letti in Python usando, ad esempio, il pacchetto PyTables o h5py